Gökçay, Erhan

Loading...

Profile URL

Name Variants

Gokcay, E

E.,Gökçay

Gökçay,E.

E., Gökçay

G.,Erhan

Gokcay E.

Goekcay, Erhan

Gokcay, Erhan

Erhan, Gokcay

Gökçay, Erhan

E., Gokcay

GOKCAY, E

Erhan, Gökçay

Gokcay,E.

Gökçay E.

G., Erhan

E.,Gokcay

E.,Gökçay

Gökçay,E.

E., Gökçay

G.,Erhan

Gokcay E.

Goekcay, Erhan

Gokcay, Erhan

Erhan, Gokcay

Gökçay, Erhan

E., Gokcay

GOKCAY, E

Erhan, Gökçay

Gokcay,E.

Gökçay E.

G., Erhan

E.,Gokcay

Job Title

Doktor Öğretim Üyesi

Email Address

erhan.gokcay@atilim.edu.tr

Main Affiliation

Software Engineering

Status

Website

ORCID ID

Scopus Author ID

Turkish CoHE Profile ID

Google Scholar ID

WoS Researcher ID

Sustainable Development Goals

3

GOOD HEALTH AND WELL-BEING

1

Research Products

9

INDUSTRY, INNOVATION AND INFRASTRUCTURE

1

Research Products

Documents

16

Citations

392

h-index

7

Documents

15

Citations

291

Scholarly Output

20

Articles

6

Views / Downloads

68/605

Supervised MSc Theses

5

Supervised PhD Theses

2

WoS Citation Count

34

Scopus Citation Count

49

WoS h-index

3

Scopus h-index

3

Patents

0

Projects

0

WoS Citations per Publication

1.70

Scopus Citations per Publication

2.45

Open Access Source

4

Supervised Theses

7

Google Analytics Visitor Traffic

| Journal | Count |

|---|---|

| Multimedia Tools and Applications | 3 |

| 2017 IEEE 1st Ukraine Conference on Electrical and Computer Engineering, UKRCON 2017 - Proceedings -- 1st IEEE Ukraine Conference on Electrical and Computer Engineering, UKRCON 2017 -- 29 May 2017 through 2 June 2017 -- Kyiv -- 131763 | 1 |

| 24th IEEE International Conference on Electronics, Circuits and Systems (ICECS) -- DEC 05-08, 2017 -- Batumi, GEORGIA | 1 |

| 7th International Conference on Cloud Computing and Services Science (CLOSER) -- APR 24-26, 2017 -- Porto, PORTUGAL | 1 |

| 8th International Conference on Cloud Computing and Services Science (CLOSER) -- MAR 19-21, 2018 -- Funchal, PORTUGAL | 1 |

Current Page: 1 / 3

Scopus Quartile Distribution

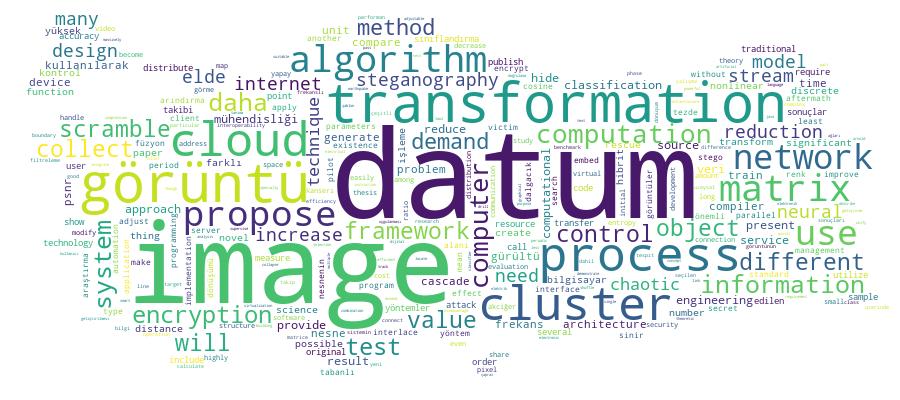

Competency Cloud

20 results

Scholarly Output Search Results

Now showing 1 - 10 of 20

Article Entropy Based Streaming Big-Data Reduction With Adjustable Compression Ratio(Springer, 2023) Gokcay, ErhanThe Internet of Things is a novel concept in which numerous physical devices are linked to the internet to collect, generate, and distribute data for processing. Data storage and processing become more challenging as the number of devices increases. One solution to the problem is to reduce the amount of stored data in such a way that processing accuracy does not suffer significantly. The reduction can be lossy or lossless, depending on the type of data. The article presents a novel lossy algorithm for reducing the amount of data stored in the system. The reduction process aims to reduce the volume of data while maintaining classification accuracy and properly adjusting the reduction ratio. A nonlinear cluster distance measure is used to create subgroups so that samples can be assigned to the correct clusters even though the cluster shape is nonlinear. Each sample is assumed to arrive one at a time during the reduction. As a result of this approach, the algorithm is suitable for streaming data. The user can adjust the degree of reduction, and the reduction algorithm strives to minimize classification error. The algorithm is not dependent on any particular classification technique. Subclusters are formed and readjusted after each sample during the calculation. To summarize the data from the subclusters, representative points are calculated. The data summary that is created can be saved and used for future processing. The accuracy difference between regular and reduced datasets is used to measure the effectiveness of the proposed method. Different classifiers are used to measure the accuracy difference. The results show that the nonlinear information-theoretic cluster distance measure improves the reduction rates with higher accuracy values compared to existing studies. At the same time, the reduction rate can be adjusted as desired, which is a lacking feature in the current methods. The characteristics are discussed, and the results are compared to previously published algorithms.Master Thesis Videoda Nesne Takibi için Hibrit Metot Geliştirmesi(2019) Taşan, Hakan; Gökçay, ErhanVideodaki nesnenin algılanması ve takibi, bilgisayarla görü ve görüntü işlemede önemli bir araştırma alanı olarak ortaya çıkmıştır. Nesne takibi için birçok algoritma geliştirilmiştir ve her algoritmanın başarılı veya başarısız olduğu bazı koşullar vardır. Bu tezde, videoda nesne takibi amacıyla üç nesne tespiti ve takibi algoritmasından oluşan güçlü bir karma sistem önerilmiştir. Bunlar şablon eşleştirme, renk histogramı ve özellik çıkarımına dayalı SURF algoritmalarıdır. Bu algoritmaları hibrit sistemde uygulamak için OpenCV kütüphanesi kullanılmıştır. Algoritmalar uygulanırken; gaussian blur, renk uzayı dönüşümleri, Otsu eşiklemesi, kayan pencere yaklaşımı, özellik çıkarımı ve betimlemesi, ve uzaklık hesaplamaları gibi farklı teknikler uygulanmıştır. Videodaki herhangi bir nesne seçilebilir ve seçilen nesne videonun geri kalanında takip edilebilir. Nesnenin tıkanmasını önlemek ve sahnenin ani hareketinin etkilerini en aza indirmek için, videonun her beşinci karesinde seçilen nesnenin yenilenmesi yaklaşımı kullanılır. Hibrit sistemin amacı, video karelerindeki takip edilecek nesnenin tespit oranını iyileştirmektir. Tüm performans testleri NTU-VOI 2018, Visual Tracker Benchmark 2013, NfS 2017 ve Davis 2017 veri setleri üzerinde gerçekleştirilmiştir. Önerilen hibrit sistemin test sonuçları, üç ayrı tespit ve takip algoritmasının sonuçlarıyla karşılaştırılmıştır. Sonuçlar, hibrit sistemin video nesne takibi için işlem süresi dışında en iyi performansı verdiğini göstermektedir.Article Citation - WoS: 12Citation - Scopus: 15A Novel Data Encryption Method Using an Interlaced Chaotic Transform(Pergamon-elsevier Science Ltd, 2024) Gokcay, Erhan; Tora, HakanWe present a novel data encryption approach that utilizes a cascaded chaotic map application. The chaotic map used in both permutation and diffusion is Arnold's Cat Map (ACM), where the transformation is periodic and the encrypted data can be recovered. The original format of ACM is a two-dimensional mapping, and therefore it is suitable to randomize the pixel locations in an image. Since the values of pixels stay intact during the transformation, the process cannot encrypt an image, and known-text attacks can be used to get back the transformation matrix. The proposed approach uses ACM to shuffle the positions and values of two-dimensional data in an interlaced and nested process. This combination extends the period of the transformation, which is significantly longer than the period of the initial transformation. Furthermore, the nested process's possible combinations vastly expand the key space. At the same time, the interlaced pixel and value transformation makes the encryption highly resistant to any known-text attacks. The encrypted data passes all random-data tests proposed by the National Institute of Standards and Technology. Any type of data, including ASCII text, can be encrypted so long as it can be rearranged into a two-dimensional format.Conference Object Citation - WoS: 1Citation - Scopus: 2An on Demand Virtual CPU Arhitecture based on Cloud Infrastructure(Scitepress, 2017) Gokcay, ErhanCloud technology provides different computational models like, including but not limited to, infrastructure, platform and software as a service. The motivation of a cloud system is based on sharing resources in an optimal and cost effective way by creating virtualized resources that can be distributed easily but the distribution is not necessarily parallel. Another disadvantage is that small computational units like smart devices and less powerful computers, are excluded from resource sharing. Also different systems may have interoperability problems, since the operating system and CPU design differs from each other. In this paper, an on demand dynamically created computational architecture, inspired from the CPU design and called Cloud CPU, is described that can use any type of resource including all smart devices. The computational and data transfer requirements from each unit are minimized. Because of this, the service can be created on demand, each time with a different functionality. The distribution of the calculation over not-so-fast internet connections is compensated by a massively parallel operation. The minimized computational requirements will also reduce the interoperability problems and it will increase fault tolerance because of increased number of units in the system.Master Thesis Kademeli Evrişimli Sinir Ağlarında Uyarlanabilir Ağ Seçimi Tekniği(2023) Önal, Ekin Sarp; Gökçay, ErhanDinamik sinir ağı, derin öğrenmede önemli bir araştırma alanıdır. Sunulan tez, statik modellerin verimliliğini ve uyarlanabilirliğini artırmak için iki veya daha fazla sinir ağını artan derinlikte bağlamak için bir yönlendirici kullanan kademeli sinir ağına odaklanmaktadır. Bu tezde, kademeli derin sinir ağlarında ağ seçimi için parametresiz bir teknik önerdik. Bu teknik, sığ ağların da birçok örneği doğru bir şekilde sınıflandırabilmesi gerçeğinden yararlanarak, eğitim ve çıkarım için gereken hesaplama süresini azaltmayı amaçlamaktadır. Kademeli sinir ağı, softmax marjı ve klasik LeNet modelinin kısa bir açıklamasını takiben, yeni bir kademeli sinir ağı algoritması tanıtılmaktadır. Önerilen model; MNIST, EMNIST ve Fashion-MNIST veri kümelerinde etkinlik ve performans açısından LeNet ile karşılaştırılmaktadır. Sayısal sonuçlar, önerilen teknikle referans modelinin verimliliğinin büyük ölçüde arttığını ve doğruluktan ödün vermeden geliştirildiğini göstermektedir.Master Thesis Akciğer Kanseri Histopatolojik Görüntü Sınıflandırmasının K-kat Çapraz Doğrulama ve Vahanade Tabanlı Dijital Görüntü İşleme Hattı Kullanılarak Geliştirilmesi(2025) Vesek, Mehmet Çağlar; Gökçay, ErhanKüresel kanser ölümlerinin önde gelen nedeni olan akciğer kanseri, kesin ve etkili tanı çözümleri gerektirir. Bu çalışma, LC25000 veri setinden yinelenenleri kaldırarak, üç sınıfta 14195 dengeli görüntüye (4727/4744/4724) düşüren yeni bir ön işleme adımı sunar; bu daha önce belgelenmemiş bir iyileştirmedir. 5 katlı çapraz doğrulama (5 epoch) altında InceptionResNetV2 ve ConViT-Small kullanılarak yapılan ilk sınıflandırma, hiperparametre ayarlaması olmadan benzeri görülmemiş bir maliyet etkinliği göstererek neredeyse mükemmel doğruluk (≤6 hata) elde etti. Daha düşük hesaplama gereksinimi nedeniyle seçilen ConViT-Small, TIFF dönüştürme ve renk normalizasyonu yoluyla daha da optimize edildi. Test edilen yöntemler arasında, Vahanade'nin dönüşümü Reinhard ve hibrit tekniklerden (örn. DCT-DWT, CLAHE) daha iyi performans göstererek, mükkemel doğruluk (0 hata), Kappa ve MCC puanları elde etti. Veri seti iyileştirme, hafif derin öğrenme ve sağlam görüntü işlemeyi entegre ederek, bu çalışma yüksek doğruluklu akciğer kanseri sınıflandırmasını ilerletiyor ve tıbbi görüntüleme için ölçeklenebilir çözümler sunuyor.Conference Object Effect of Secret Image Transformation on the Steganography Process(Ieee, 2017) Buker, Mohamed; Tora, Hakan; Gokcay, ErhanSteganography is the art of hiding information in something else. It is favorable over encryption because encryption only hides the meaning of the information; whereas steganography hides the existence of the information. The existence of a hidden image decreases Peak Signal to Noise Ratio (PSNR) and increases Mean Square Error (MSE) values of the stego image. We propose an approach to improve PSNR and MSE values in stego images. In this method a transformation is applied to the secret image, concealed within another image, before embedding into the cover image. The effect of the transformation is tested with Least Significant Bit (LSB) insertion and Discrete Cosine Transformation (DCT) techniques. MSE and PSNR are calculated for both techniques with and without transformation. Results show a better MSE and PSNR values when a transformation is applied for LSB technique but no significant difference was shown in DCT technique.Doctoral Thesis Görüntü Füzyonu Kullanarak Tıbbi Görüntülerden Gürültü Arındırma(2020) Sıddık, Omer Subhı Sıddık; Gökçay, ErhanGörüntü füzyonu birçok erişilebilir görüntüden birinci kalite görüntü alma sistemidir. En önemli yöntem yüksek geçirim filtreleme yöntemidir. Daha sonraki yöntemler Dual-Tree Complex DWT (DTCWT), tek-tip rasyonel filtre bankası ve piramit teknikleri üzerine kuruludur. Bu tez çalışması, sefalometrik röntgen görüntülerinde Gaussian ve Poisson gürültü arındırma yöntemleri üzerinden görüntü birleştirme konusunu ele almaktadır. Görüntünün iletilmesi ve toplanması esnasında hedefsiz haberleşme ve ekipman yetersizliği gibi nedenlerden ötürü dijital görüntü uygulamaları hata vermektedir. Korumasız iletim nedeni ile zarar görmüş görüntüler farklı sensörler aracılığı ile tespit edilir. Gürültü arındırma işlemi sonrasında elde edilen görüntüler, yüksek kalite çözünürlüğe sahip tek bir görüntü elde etmek için birbirleri ile birleştirilirler. Tek bir nihai görüntü elde etmek için iki veya daha fazla görüntünün birleştirilmesi işlemine görüntü füzyonu denilir. Bu tezde farklı görüntü füzyon algoritmaları ve (Gaussian ve Poisson) gürültü filtreleri kullanıldı. 4. bölümde yer alan metodoloji ve sonuç kısmı yirmi bir yöntemden oluşmaktadır. Bu yöntemlerden ilk on üç tanesi bu tez çalışması ile alakalı olan görüntü güçlendirme yöntemlerini içermektedir ve yine bu yöntemler tarafımızca önerilen gürültü arındırma işleminde kullanılmıştır. Bu yöntemler şu şekilde sunulmuştur: Görüntü gürültü arındırma işlemimde ilk sekiz yöntem eşikleme ve küçültme yöntemleri kullanılarak sunulmuş, sonrasında iki adet filtre yöntemi görüntü filtreleme de sunulmuş ve son olarak da üç yöntem füzyon yöntemlerinde kullanılmıştır. Son sekiz yöntem çok sayıda aşamadan oluşmaktadır ve bu aşamaların her biri önceden test edilmiş olan en iyi sonuçlar ele alınarak gerçekleştirilmiştir. Bu tez çalışmasında, 'Dual-Tree Complex Discrete Wavelet Transform' olarak adlandırılan çok sensörlü dönüşüm bazlı füzyon teknolojileri ile birlikte elde edilen 400 sefalometrik röntgen görüntülerini kullanan farklı yöntemler kullanılmıştır. Sinyal, 'Dual-Tree Complex Discrete Wavelet Transform' kullanılarak farklı frekans alt bantlarına ayrıştırılmıştır. Düşük frekanslı alt bantlardan gürültüyü arındırmak için iki yanlı filtreleme yöntemi kullanılmış, yüksek frekanslı alt bantlar için ise 'Bivariate Shrinkage' dalgacık eşiklemesi kullanılmıştır. Gürültüden arındırılmış alt bantlar, dalgacık dönüşüm füzyon kuralı esas alınarak birleştirilmiştir. Test sonuçları bu birleştirme algoritmalarının yüksek kaliteli bir görüntü ortaya çıkardığını göstermektedir.Conference Object Citation - Scopus: 2A Stream Clustering Algorithm Using Information Theoretic Clustering Evaluation Function(Scitepress, 2018) Gokcay, ErhanThere are many stream clustering algorithms that can be divided roughly into density based algorithms and hyper spherical distance based algorithms. Only density based algorithms can detect nonlinear clusters and all algorithms assume that the data stream is an ordered sequence of points. Many algorithms need to receive data in buckets to start processing with online and offline iterations with several passes over the data. In this paper we propose a streaming clustering algorithm using a distance function which can separate highly nonlinear clusters in one pass. The distance function used is based on information theoretic measures and it is called Clustering Evaluation Function. The algorithm can handle data one point at a time and find the correct number of clusters even with highly nonlinear clusters. The data points can arrive in any random order and the number of clusters does not need to be specified. Each point is compared against already discovered clusters and each time clusters are joined or divided using an iteratively updated threshold.Conference Object A Decentralized on Demand Cloud Cpu Design With Instruction Level Virtualization(Springer Verlag, 2018) Gokcay,E.Cloud technology provides many advantages and provides many services over traditional computational models. Although the provided virtual services increase resource sharing and cost effectiveness of the system, each node in the system is still centralized. Different CPU and OS versions bring interoperability problems in data exchange between nodes. In most cases less powerful units are left outside the service area. These units can only be considered as consumers of the cloud system. A new service called Cloud CPU is described elsewhere where the cloud provides the computational background for the components of a virtual CPU and the computation is distributed over internet. The design is using all units connected to the internet and it achieves a massively parallel operation. In this paper, the design of Cloud CPU will be extended and description of services needed with the new architecture will be discussed. One of the new services needed is a multi-language compiler where the target language is not fixed as well as the source language. The job of the compiler is not using the cloud for execution but to distribute the computation depending on the provided instruction sets published by each node. The computation makes sense only when all units work together and there is a need to synchronize and connect all nodes included in a particular computation. The need for synchronization will be gone when the computation is finished. Therefore an on demand Cloud-OS service is needed for bookkeeping and synchronization. The need for the Cloud-OS is temporary and the on demand initiated Cloud-OS will be terminated when the computation is ended. © Springer International Publishing AG, part of Springer Nature 2018.